Qu’est-ce que le Big Data (bigdata) ?

Big data, big business.

Table des matières

J’ai brièvement présenté quelques études de cas à propos du #bigdata dans mes derniers articles. Avant de réutiliser ces cas pour présenter un schéma de l’évolution des sources de données analysées en entreprise, je pense qu’il serait à propos de donner une définition du Big Data.

Il est à noter que j’aurais bien aimé présenter deux autres études de cas à propos du big data, soit:

- « Big Data, big hacking » qui aurait présenté le vol des données sur le réseau PlayStation au printemps 2011, et;

- « Big data mobile », un autre cas concernant plutôt le déluge des données sur les appareils mobiles (cellulaires ou autres tablettes).

Si vous avez déjà produit quelque chose là dessus (ou si vous avez d’autres idées…), n’hésitez pas à m’écrire et je ferai un beau lien vers votre article en l’incluant dans le corps d’un de mes textes en utilisant les mots clés juteux que vous visez, ce qui fera frétiller les moteurs de recherche de bonheur tout en vous permettant de faire des conversions (jusqu’à ce que Google change à nouveau ses algorithmes).

(Brève) histoire du Big Data

Le Big Data n’est pas un phénomène nouveau; en fait, tel que mentionné par M. Floyer le 28 février dernier sur le site Wikibon beta, cette discipline vit le jour avec l’émergence de données trop volumineuses pour être manipulées à l’aide de techniques traditionnelles. Ce sont les entreprises de moteurs de recherche qui furent les premières à l’utiliser. En effet, lorsque ces entreprises rencontrèrent des problèmes avec les grandes quantités de données plutôt mal structurées, elle dûrent trouver une solution. La toute première compagnie à réagir fut Google. Tout cela commença lorsque

“Google started its search operation it realized that it couldn’t suck this huge volume of dispersed information into a data temple – it just wouldn’t work – so it developed MapReduce and the early days of big data were born which led to Doug Cutting and his friends inventing Hadoop (with some help from Yahoo) and then this whole ecosystem around big data and Apache, Cassandra, Cloudera and a zillion other important pieces has exploded” (Wikibon blog, 2011).

Fait cocasse, M. Cutting nomma Hadoop en l’honneur de l’éléphant en peluche de son petit garçon.

À ses débuts, le Big Data était utilisé par des entreprises telles que des banques (ex: Visa et Bank of America) pour ce qui concerne les transactions par cartes de crédit et usages reliés au marché financier, par des compagnies de téléphone (ex: AT&T) pour les registres d’appels téléphoniques et par des sites de commerce électronique (ex: Amazon et Ebay) pour améliorer le service en ligne. Bien que le Big Data ait commencé dans des industries spécifiques, et surtout pour des gros joueurs, il est maintenant accessible à tous, même les petites PME à leurs débuts.

Définition du BigData

Tout d’abord, il est important de spécifier que le Big Data n’a pas une définition arrêtée. De nombreuses variantes de descriptions sont retrouvées mais, bien sûr, elles sont similaires et renferment les mêmes concepts. Pour expliquer cette variation, nous pouvons dire que ce terme est relatif à l’entreprise concernée. Dans son article Qu’est-ce que le Big Data, M. Lessard de ZeroSeconde le définit comme étant

« une expression qui circule depuis quelque temps dans la niche hi-tech de l’informatique dématérialisée (computer in the cloud) et qui fait référence aux outils, processus et procédures permettant à une entreprise de créer, manipuler et gérer de très larges quantité de données » (Lessard, 2010).

Tandis que, dans la définition big data (BigData), publiée sur le site de TechTarget, le terme est défini comme un terme général utilisé pour décrire les quantités volumineuses de données, structurées ou non, créées par une entreprise. Ces données

“would take too much time and cost too much money to load into a relational database for analysis. Although Big data doesn’t refer to any specific quantity, the term is often used when speaking about petabytes and exabytes of data” (SearchCloudComputing.com, 2011).

Caractéristiques du Big Data

Selon Floyer, les principales caractéristiques du Big Data sont:

- “Very large distributed aggregations of loosely structured data – often incomplete and inaccessible:

- Petabytes/exabytes of data,

- Millions/billions of people,

- Billions/trillions of records,

- Loosely-structured and often distributed data,

- Flat schemas with few complex interrelationships,

- Often involving time-stamped events,

- Often made up of incomplete data,

- Often including connections between data elements that must be probabilistically

- inferred, Applications that involved Big-data can be:

- Transactional (e.g., Facebook, PhotoBox), or,

- Analytic (e.g., ClickFox, Merced Applications)” (2011).

Isolons quelques aspects fondamentaux de ces caractérisitiques.

Volume ET gestion du volume

De plus en plus, les entreprises sont ensevelies sous une quantité phénoménale de données qui croît à vive allure, entraînant le besoin de revoir la gestion et manipulation de ces données qui sont à l’état brut. Tel que mentionné par Tony Bain, le Big Data, bien que son nom laisse présager une question de volume, fait plutôt référence à la combinaison du volume ET de notre usage des données. Le Big Data ne fait donc pas référence uniquement aux “données”, mais fait appel à de nouvelles technologies axées sur la recherche et l’innovation afin de bien les gérer.

Nouveaux outils, nouvelles techniques d’analyse

Quant à lui, Dan Kusnetzky, de ZDNet, affirme que le terme Big Data

“refers to the tools, processes and procedures allowing an organization to create, manipulate, and manage very large data sets and storage facilities” (Kusnetzky, 2010).

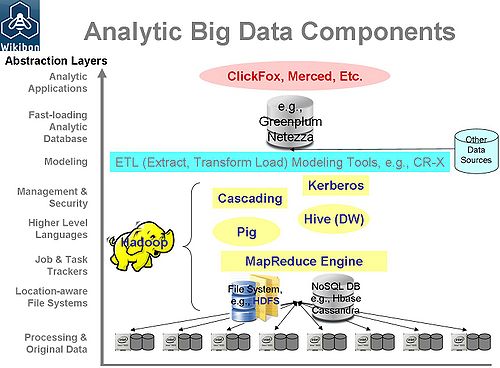

Pour aider à visualiser le principe des techniques utilisées pour l’analyse de Big Data, voici un schéma représentant les composants d’un système d’analytiques du Big Data :

Entreposage des données

Pour sa part, M. Latamore de Wikibon beta

“defines “big data” as data blocks that require a new storage architecture, either because of their size, performance constraints, distribution constraints, and/or presentation requirements” (Latamore, 2011).

Vitesse en temps réel

M. Lindstedt, en réponse à la question de M. Tung sur le site de Focus, partage que son

“interpretation of Big Data is to say anything at or above 500TB, with a loading speed of 1TB / HR (going in to the system), and 2000 to 5000 on-line users using over 70% of the data available” (Tung, 2011).

Information non structurée

Toujours sur le site de Focus, cette fois, c’est M. Devlin qui répond à M. Tung en mentionnant que la taille absolue des données n’a que peu de signification et, qu’en fait, le Big Data peut être décrit comme de l’information non-traditionnelle. Cette information non-traditionnelle pourra être utilisée pour identifier des tendances récurrentes pour l’entreprise.

Informatique dans les nuages

Ces exemples ne sont qu’un échantillon des définitions retrouvées pour décrire le Big Data. Afin de compléter la description du terme, il est bien de spécifier que

“Big data analytics is often associated with cloud computing because the analysis of large data sets in real-time requires a framework like MapReduce to distribute the work among tens, hundreds or even thousands of computers” (SearchCloudComputing.com, 2011).

Y a-t-il d’autres caractéristiques du Big Data qui vous paraissent fondamentales? Venez continuer la conversation sur Google +.

L’illustration provient de dataspora.